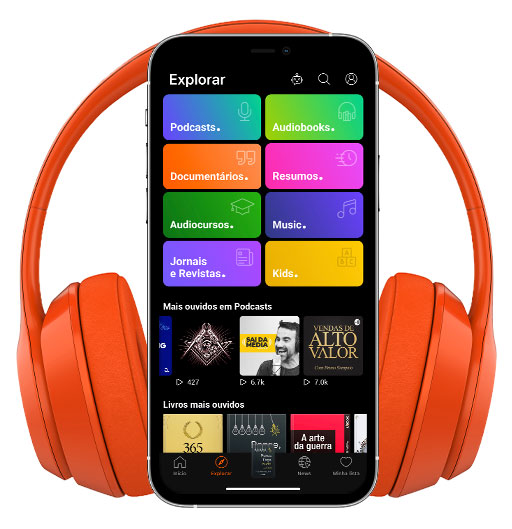

Le monde de demain - The Flares [PODCASTS]

#28 - Super IA, Risques existentiels, Paradoxe de Fermi et lointain futur – avec Stuart Armstrong

- Autor: Vários

- Narrador: Vários

- Editor: Podcast

- Duración: 1:31:42

- Mas informaciones

Informações:

Sinopsis

⚠️ Découvrez du contenu EXCLUSIF (pas sur la chaîne) ⚠️ ⇒ https://the-flares.com/y/bonus/ ⬇️⬇️⬇️ Infos complémentaires : sources, références, liens... ⬇️⬇️⬇️ Sommaire : 0:01:15 Présentation de Stuart Armstrong 0:01:51 Quelques mots sur le Future of Humanity Institute 0:03:49 Qu'est ce que AGI (IAG) et super IA ? 0:06:31 Quel impact pour le monde si nous réussissons à développer une IA générale ? 0:09:47 Quelle approche semble etre la plus prometteuse pour développer une IAG ? 0:12:58 Une fois que nous avons conçu une IAG, il peut y avoir un décollage lent ou rapide vers une IA bien supérieure à l’humanité. Qu’est ce qui est le plus probable ? 0:18:21 Qu’est ce qu’une super IA pourrait faire concrètement ? Notamment dans le monde physique et pourquoi ça représente un risque existentiel ? 0:22:10 Quelles sont les pistes pour résoudre le problème du contrôle et l’alignement des valeurs ? 0:32:07 Est ce que les politiciens prennent au sérieux les enjeux de l’IA ? 0:34:02 Quels sont les points positifs d’une sup

![Le monde de demain - The Flares [PODCASTS]](http://media3.ubook.com/catalog/book-cover-image/720284/400x400/A2713F91-897C-3A51-D6EF-90208418C4B0.jpg)